Mein Zwischenfazit zu ChatGPT:

Meine ersten Artikel zu "KI" - damals noch ein eher unbekannter Begriff - habe ich 1984 verfasst (also vor rund 40 Jahren!). Aufgrund der Faszination für englische Textadventures (Stichwort Infocom, Zork) habe ich mich an das damals als unmachbar geltende gewagt, einen Parser zu entwickeln, der mit der als zu kompliziert geltenden deutschen Grammatik umgehen konnte. Spracheingaben müssen von einem Spiel nicht nur verstanden werden, es muss auch passend darauf reagieren können. Das führte zwangsläufig in die Welt von "Eliza".

Gesprächspartner zum Abtippen

Als Übung habe ich damals Eliza eingedeutscht und auch eine selbstlernende Variante entwickelt. Kürzlich habe ich einen alten Beitrag mit einem Listing (Programm zum Abtippen) von mir im Speicher entdeckt der den Titel "Ein Gesprächspartner zum Abtippen" trägt (muss ich vielleicht mal Scannen und hier reinstellen). Es gilt zu bedenken, dass das alles quasi in einer Zeit passierte als Rechner (eher Heimcomputer) vergleichsweise stinklahm und mehr als 64 KByte Speicher schon fast unbezahlbarer Luxus waren.

Und mit dieser "Witz-Hardware" wurden damals sogar schon Expertensysteme ("selbstlernende" Programme) in der dafür gängigen Sprache "Prolog" geschrieben, über "Lisp" reden wir besser nicht.

Alter Wein in neuen Schläuchen

Ich erzähle das hier um mal klar aufzuzeigen, dass die Idee einer "KI", die über natürliche Sprache bedient wird, gespeichertes Wissen auswertet und mit natürlicher Sprache antwortet nicht alt sondern uralt ist. Die notwendigen Methoden wurden bereits vor einer Ewigkeit ersonnen. Das hat damals natürlich nur begrenzt funktioniert, weil Rechner halt lahm und Speicher sehr knapp war.

Heute ist die Hardware vergleichsweise unvorstellbar stärker geworden. Für eine "KI" wie ChatGPT steht prinzipiell unbegrenzte Rechenleistung und unbegrenzter Speicher parat. Und sie kann ihre Wissensbasis aus dem "unendlich" wachsenden Pool des Internet beziehen.

Viele Bekannte von mir wundern sich, warum ich mich (bis gestern) noch nicht mit ChatGPT beschäftigt habe. Vielleicht fehlt mir die Muse an diesem Hype teilzuhaben, weil ich mir anmaße mich mit den Grundlagen dieses "KI"-Krempels recht gut auszukennen. Die Mechanismen von ChatGPT sind knallhart gesagt die gleichen wie einst jene von Abenteuerspielen.

Früher hart heute Gimmick

Eingehende Sprache zu analysieren - konkret muss es eigentlich heißen "das Verständnis einer Spracheingabe vorzugaukeln" - ist Gimmick. Wissen in natürlichsprachlichem Format auszugeben und "umzuformulieren" ist ebenfalls Gimmick. Einem Rechner gewaltiges Wissen bereitzustellen (Internet) ist wiederum Gimmick. Ein bisschen aufwändiger ist es vielleicht ein selbstlernendes Regelwerk zu bauen, das diese Komponenten steuert.

Dieses Regelwerk kann durch die heutigen Möglichkeiten selbsterklärend so komplex werden, dass selbst seine Entwickler irgendwann nicht mehr verstehen, was es eigentlich exakt tut. Dann entsteht ein Dingsbums bei dem halt was rein geht und dann was raus kommt und keiner mehr schnallt, wie das Ergebnis entstanden ist. Und das wird jetzt eben als "Künstliche Intelligenz" gehypt. Eigentlich müsste es "ein Ding von dem man nicht weiß was es eigentlich genau tut" heißen.

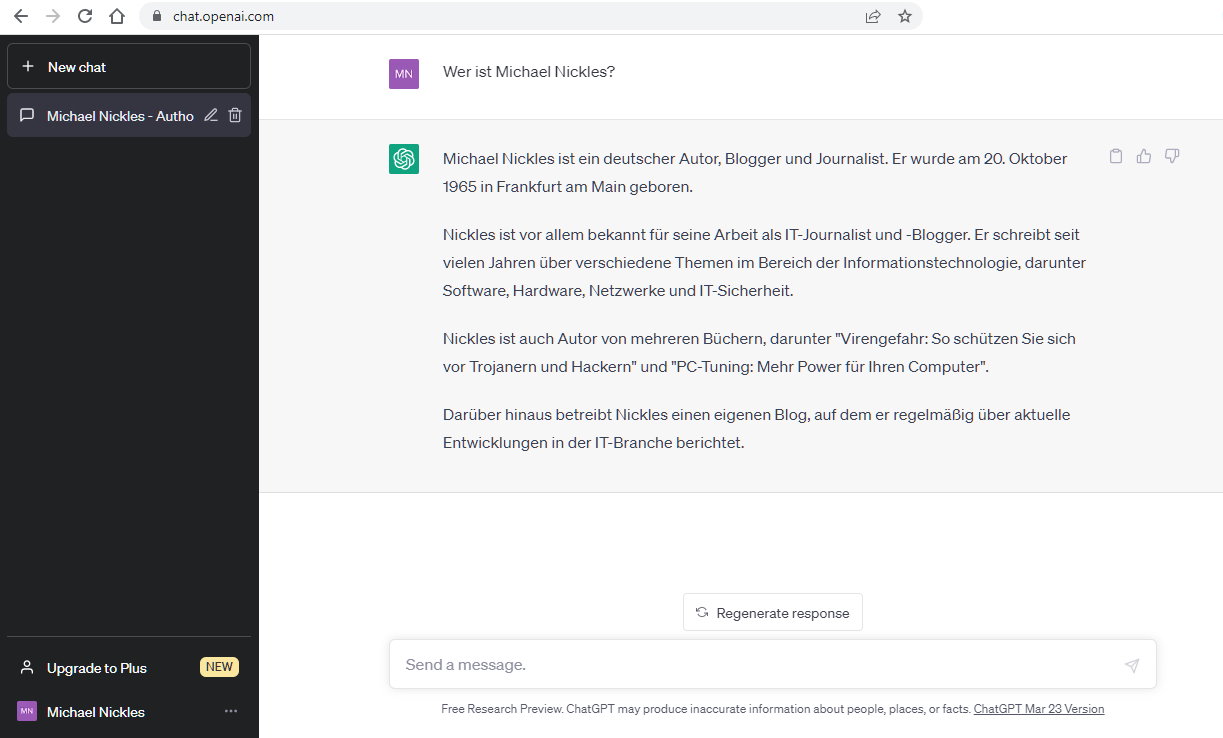

Zu meiner Unterhaltung mit ChatGPT beziehungsweise Befragung über mich selbst stelle ich fest:

ChatGPT macht seinen Job scheinbar beeindruckend gut, suggeriert (wie ein gutes Textadventure) Sprache inhaltlich zu verstehen und lässt seine Ergebnisse auch sehr gut sprachlich raus. Das Regelwerk zwischen diesen beiden Dingen und die verwendete Wissensbasis scheint mir fragwürdig.

Warum hat ChatGPT nicht in Wikipedia nach "Michael Nickles" nachgeschlagen? Es hätte dort mühelos feststellen können, dass der dortige Beitrag von mir schon recht alt und auch gepflegt ist, die Informationen also einen durchaus hohen Glaubwürdigkeitsfaktor haben. Anscheinend vermeiden es die ChatGPT-Mache ausdrücklich, Wikipedia-Wissen zu nutzen. Vielleicht haben sie Angst, dass dann zu schnell der Eindruck entstehen könnte, ChatGPTs Antworten seien nur umformulierte "Internetartikel" - das würde den Hype zerstören und das Milliardengeschäft, das erhofft wird.

Alles was ChatGPT wirklich richtig über mich festgestellt hat, ist eigentlich sehr wenig:

Michael Nickles ist ein bekannter IT-Autor der viele Artikel und Bücher verfasst.

Erst bei gezielter Nachfrage nach "Michael Nickles und Abenteuerspiele" hat das System erkannt, dass ich mich auch mit Abenteuerspiele-Programmierung beschäftigt habe.

Das ist eigentlich nicht besonders viel.

Erschreckend sind die Falschinformationen die ChatGPT über mich ermittelt hat beziehungsweise richtige Informationen von denen ich weiß, dass ChatGPT sie nur zufällig erraten hat, weil es diese Informationen nicht haben konnte.

- Geburtsdaten sind falsch (trotz leicht auffindbar richtigen in Wikipedia)

- ChatGPT suggeriert ich hätte für IBM und Microsoft gearbeitet (das ist falsch)

- die Buchtitel die ich angeblich geschrieben haben soll existieren nicht

- die Spiele die ich programmiert haben soll sind mir nicht einmal bekannt

- das Thema "IT-Sicherheit und Datenschutz" ist kein "Herzensthema" für mich

- nein, ich interessiere mich nicht für Fotografie

Beim genauen Betrachten der Antworten von ChatGPT fällt auf, dass sein vorgegebenes Regelwerk offensichtlich darauf trainiert ist Texte zu strecken. Es greift trickreich auf einen "Satz-/Floskelbaukasten" und unnötige Füllwörter zurück um Antworten "menschlicher" und glaubwürdiger erscheinen zu lassen. Das auch zum Preis, dass Informationen dadurch verfälscht werden.

Richtig schlimm bei ChatGPT: die Antworten werden in einer sehr glaubwürdigen Art und Weise präsentiert, Begriffe wie "eventuell", "vermutlich" und "vielleicht" scheint es nicht zu geben. Das "KI-Wissen" kommt in der Form "das sind die Fakten" rüber. Auch verrät ChatGPT natürlich nicht, wie es auf seine Antworten gekommen ist, aus welchen Quellen es sein Wissen bezogen hat. Das macht es schwer und zeitraubend den Wahrheitsgehalt der Aussagen zu verifizieren.

Okay. Vielleicht ist es der falsche Ansatz ChatGPT über sich selbst (also in diesem Fall mich selbst) zu befragen. Natürlich kann das Ding mehr.

Ein Freund hat mir gestern Abend (bevor ich ChatGPT erstmals selbst probiert habe) sehr begeistert erzählt, dass er sich "Programme" von ChatGPT entwickeln lässt und damit viel Zeit spart. Ich habe mir zwischenzeitlich noch den Spaß erlaubt ChatGPT mal zu bitten, mir ein "Hello World" Programm in C# zu schreiben.

Das hat ChatGPT super und tadellos richtig gemacht. Ich habe dann die völlig blödsinnige Aufgabe gestellt dieses Programm komplizierter zu machen. Auch das hat ChatGPT sagenhaft erledigt und auch sehr sehr gut kommentiert. Ich habe die "KI" dann schrittweise gebeten, das "Hello World" noch komplizierter zu machen. Der finale Auftrag lautete schließlich "schreibe in c# das schlechteste hello world programm aller zeiten". Auch das hat ChatGPT geschafft und mich baff gemacht. Schlechter und komplizierter (aber dennoch funktionierend) geht es nicht. Und wie "humorvoll" ChatGPT seine Programmierbeispiele und meine "Aufträge" kommentiert hat, war schlichtweg beeindruckend.

Ich hatte so viel Spaß, dass ich diese "Unterhaltung" noch im Programmieren-Forum von Nickles.de veröffentlichen werden um Euch daran teilhaben zu lassen.

Vielleicht werden ChatGPT und ich Freunde.