Früher war die Sache klar: Der Prozessor des Computers war dazu da, um etwas auszurechnen, und die Grafikkarte, um etwas am Bildschirm darzustellen. Doch Grafikkarten (GPUs) werden immer leistungsfähiger, nicht zuletzt durch hohe Anforderungen von Computerspielen im 3D-Bereich.

Daher kann man sie mittlerweile auch für ganz andere Dinge verwenden, zum Beispiel für wissenschaftliche Simulationsrechnungen.

Am Institut für Mikroelektronik der TU Wien werden Rechenmethoden entwickelt, mit denen man die speziellen Vorteile von Grafikkarten optimal für die Wissenschaft nutzen kann. Der Grafikkartenhersteller Nvidia zeichnet diese Leistungen in diesem Bereich nun aus, indem er das Forschungsteam von Karl Rupp zum „Nvidia GPU Research Center“ macht und auf vielfältige Weise unterstützt.

Hochparalleles Rechnen

„Das Besondere an Grafikkarten ist, dass sie hochgradig parallel rechnen können“, sagt Karl Rupp, der Leiter des GPU Research Centers. „Ein moderner Prozessor hat vielleicht vier Prozessoren, die gleichzeitig Rechenaufgaben lösen können, eine Grafikkarte hingegen kann tausende Threads gleichzeitig abarbeiten.“

Gerade Grafik-Berechnungen lassen sich oft sehr gut in Teilaufgaben zerlegen, die nicht aufeinander aufbauen, sondern gleichzeitig berechnet werden können. Bei anderen Rechenaufgaben hingegen kann man den nächsten Schritt immer erst ausführen, wenn der vorhergehende Schritt fertig berechnet worden ist. Solche Aufgaben sind dann von Grafikkarten nur schwer zu lösen. Ob eine Grafikkarte oder eine herkömmliche CPU schneller zu einem Rechenergebnis kommt, hängt von der Art der Rechenaufgabe ab.

Gemeinsam mit seinen Kollegen Josef Weinbub und Florian Rudolf arbeitet Karl Rupp an Rechenmethoden, durch die man die Vorteile von Grafikkarten auch für die Wissenschaft optimal nutzen kann. „Ältere Generationen von Grafikkarten konnten nur Zahlen mit einfacher Genauigkeit verarbeiten“, sagt Rupp. „Seit 2009 oder 2010 sind nun aber auch Grafikkarten mit doppelter Genauigkeit verfügbar, wie man sie für die meisten wissenschaftlichen Simulationsrechnungen braucht. Seither sind Grafikkarten für die Wissenschaft als Alternative zum gewöhnlichen Computerprozessor interessant.“ Grafikkartenhersteller wie Nvidia haben das erkannt und wollen ihre Produkte auch für Anwendungen in der Hochleistungs-Simulationsrechnung vermarkten.

Open Source Library für die Wissenschaft

„Eigentlich haben wir als Anwender begonnen, nicht als Methodenentwickler“, sagt Karl Rupp. Am Institut für Mikroelektronik werden aufwändige Computersimulationen entwickelt, mit denen man Halbleitermaterialien und nanoelektronische Schaltungen rechnerisch untersuchen kann. Damit sich solche Rechnungen mit hoher Präzision und in möglichst kurzer Zeit lösen lassen, muss man aber auch über computertechnische und mathematische Grundlagen nachdenken.

„Wir entwickeln nun Algorithmen, mit denen man Grafikkarten optimal für wichtige mathematische Schritte wie etwa das Lösen von Gleichungssystemen verwenden kann“, erklärt Rupp. Diese Algorithmen bilden die „ViennaCL Library“ und werden gratis auf open-source-Plattformen zur Verfügung gestellt. Wer auch immer in Zukunft mit hochparallelen Grafikkarten rechnen will, kann auf die mathematischen Grundbausteine zurückgreifen, die an der TU Wien entwickelt wurden.

GPU Research Center

Die Firma Nvidia verleiht nun der Forschungsgruppe von Karl Rupp an der TU Wien (vorläufig für ein Jahr) den Status eines „Nvidia GPU Research Centers“. Das ist nicht bloß eine Auszeichnung für bisherige Leistungen, die TU Wien wird auch mit Hardware und speziellem technischen Support versorgt und wird Zugang zu besonderen Produkten und speziellen Veranstaltungen haben.

„Für uns ist das eine wunderbare Motivation, weiterhin die besten GPU-Codes für die wissenschaftliche Community zu entwickeln“, sagt Rupp. In Zukunft will man insbesondere an Algorithmen für die Verarbeitung großer Matrizen arbeiten, die man für finite Elemente-Methoden braucht – einer Familie von Methoden, die in den Ingenieurswissenschaften und der Industrie eine große Bedeutung erlangt hat.

Michael Nickles meint:

Michael Nickles meint: Dass Grafikkarten auch für andere Dinge als Grafik genutzt werden können ist ein alter Hut. Die Forscher der TU Wien scheinen sich auf jeden Fall über die rasant zunehmende Leistung zu freuen und gewiss auch über die freundliche Unterstützung von Nvidia. Irre ist übrigens, welche Leistungs- und auch Preisklassen Grafikkarten inzwischen erreicht haben.

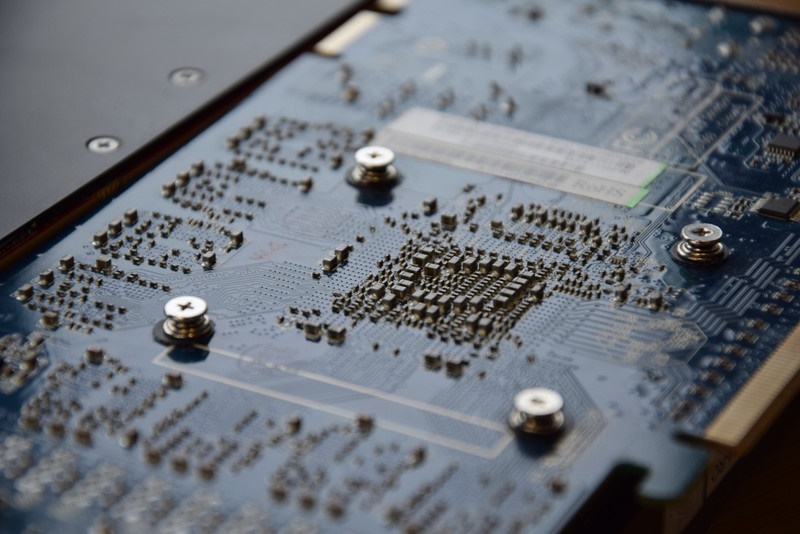

Wer jetzt an so was wie eine "Ultra Highend Gamer"-Karte um die 1.000 Euro denkt oder an einen "Doppelpack" davon denkt, liegt gnadenlos falsch. Die Rede ist eher von so was wie im Bild nebenan zu sehen. So eine Quadro 6000 kostet locker mal um 13.000 Euro (in Worten "dreizehntausend Euro"). Die Rechengewalt die hier rauskommt lässt sich vermutlich nicht mit Worten beschreiben.

Erfreulicherweise werden die neu entwickelten Algorithmen von der TU Wien als Open Source freigegeben, was die irre Leistung der Karten allen zugänglicher machen wird.